71% сотрудников беспокоятся о внедрении искусственного интеллекта в рабочие процессы. Но дело не только в страхе увольнения. Главная проблема — алгоритмическая тревожность: страх перед оценкой машиной, которая не учитывает контекст и не дает права голоса.

Почему оценка машиной страшнее оценки человека

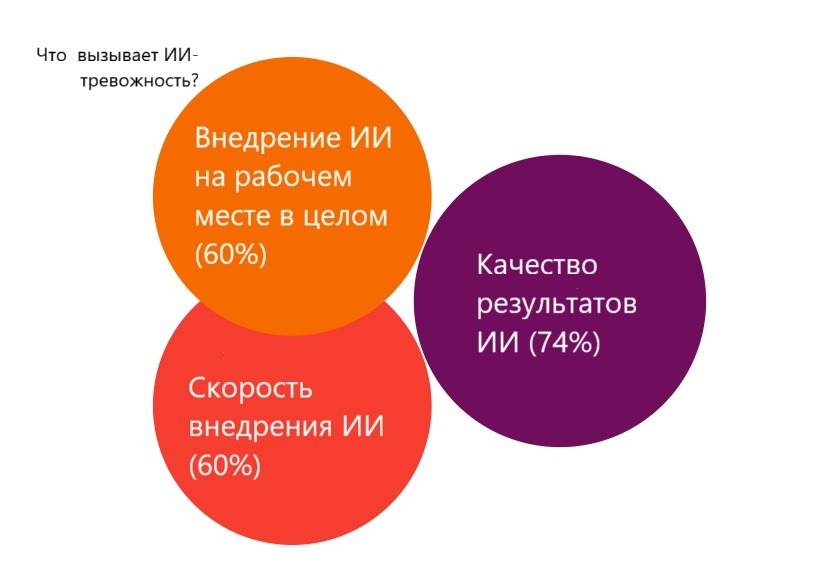

Ernst & Young выяснили, что 77% сотрудников беспокоятся о правовых рисках использования ИИ. 75% переживают о кибербезопасности. 65% тревожатся, что не знают, как использовать искусственный интеллект этично. Но главная проблема — непрозрачность. Сотрудники не понимают, по каким критериям их оценивают, и не могут повлиять на результат.

Внедрение ИИ-оценки напрямую влияет на психологическую безопасность в команде. Когда сотрудники не понимают, как система принимает решения, они начинают бояться ошибок, перестают рисковать и предлагать новые идеи. Тревога парализует.

Сотрудник готов принять негативную оценку от руководителя. С человеком можно поговорить, объяснить контекст, попросить пересмотреть решение. У босса был сложный день? Можно подождать и поднять вопрос позже. Проект провалился из-за внешних обстоятельств? Руководитель может это учесть.

Алгоритм безразличен к обстоятельствам. Болел ребенок, сломался компьютер, изменились вводные проекта — системе все равно. Она смотрит на цифры: количество выполненных задач, время ответа на письма, процент закрытых тикетов. Контекст не учитывается и объясниться невозможно.

Восемь факторов ИИ-тревожности

Исследование Бейханского университета выявило восемь ключевых факторов, вызывающих тревогу при внедрении искусственного интеллекта:

- Нарушение конфиденциальности данных. Сотрудники не знают, какие данные о них собирает система, как они хранятся и кто к ним имеет доступ. Алгоритм анализирует переписку, время работы, темп выполнения задач. Это ощущается как постоянная слежка.

- Предвзятость алгоритмов. ИИ может дискриминировать целые группы людей, даже если разработчики не закладывали это намеренно. В Amazon cистема училась на исторических данных, где большинство успешных кандидатов были мужчинами, и начала автоматически снижать оценки резюме женщин.

- Угроза сокращения рабочих мест. Если ИИ оценивает эффективность, он может и заменить. Эта связь очевидна для сотрудников, и страх потерять работу становится постоянным фоном.

- Необходимость постоянного обучения новым технологиям. Правила игры меняются. То, что работало вчера, сегодня может оцениваться иначе. Нужно постоянно адаптироваться, учиться работать с новыми инструментами. Это истощает.

- Экзистенциальная угроза. На глубинном уровне люди чувствуют: если машина может оценивать их работу, значит, она может и выполнять её. Это подрывает профессиональную идентичность.

- Этические нарушения. Непонятно, кто несет ответственность за ошибки алгоритма. Если система неправильно оценила сотрудника и он потерял премию или повышение — кто виноват? Программист? Руководитель, который внедрил систему? Сам алгоритм?

- Появление искусственного сверхразума. Хотя это звучит футуристично, беспокойство реально. Если ИИ уже принимает решения о людях, что будет дальше?

- Потеря контроля над ИИ. Системы машинного обучения развиваются и меняются. Алгоритм, который работал справедливо год назад, мог «доучиться» на новых данных и начать оценивать иначе. Никто не гарантирует, что изменения будут позитивными.

Как внедрять ИИ-оценку правильно

Три ключевых принципа помогают снизить алгоритмическую тревожность и сделать внедрение ИИ успешным:

Покажите формулу. Сотрудники должны понимать, за что они получают баллы и как рассчитывается оценка. Прозрачность критериев критически важна. Если система учитывает скорость ответа на письма — объясните это. Если важнее качество, а не количество — тоже объясните. «Черный ящик» порождает страх.

Добавьте человека. Финальное решение должен принимать руководитель, который может учесть контекст. ИИ может предоставить данные, выявить паттерны, указать на проблемы. Но окончательный вердикт — за человеком. Это сохраняет возможность диалога и обжалования.

Дайте право апелляции. Сотрудник должен иметь возможность оспорить результат алгоритма и пересмотреть оценку. Механизм обжалования — не формальность, а реальный инструмент защиты от ошибок системы. Когда люди знают, что могут отстоять свою правоту, тревожность снижается.

И, конечно, займитесь вовлечением сотрудников в разработку критериев оценки. Люди должны участвовать в создании системы, с которой им работать. Это повышает доверие и помогает избежать очевидных ошибок.

Также наладьте прозрачную коммуникацию о том, как работает система. Не достаточно один раз рассказать на общем собрании. Нужна постоянная работа: FAQ, обучающие материалы, регулярные сессии вопросов и ответов.

Инструменты Мираполис HCM и Мираполис Таланты строятся на этих принципах: система использует прозрачные метрики с объяснением каждого показателя и сохраняет человеческий контроль над финальными решениями. Система помогает анализировать данные, но не заменяет руководителя в принятии решений о людях.

Главные выводы

Алгоритмическая тревожность — реальная проблема, а не капризы сотрудников. Восемь факторов ИИ-тревожности — от нарушения конфиденциальности до потери контроля над системой — создают постоянное психологическое давление на сотрудников.

Решение существует: прозрачность критериев, сохранение человека в процессе принятия решений и право апелляции. Когда сотрудники понимают, как работает система, могут влиять на критерии оценки и имеют возможность оспорить несправедливое решение, алгоритмическая тревожность снижается. Внедрение искусственного интеллекта в оценку сотрудников — не технический проект. Это изменение культуры компании, которое требует вовлечения людей, прозрачной коммуникации и реальной заботы о психологической безопасности команды.